Blog

YANS 2019 所感: これからの言語処理コミュニティのために

自然言語処理&バックエンドエンジニアをしている澤井 (github: @tuxedocat) です。普段は、広告表示におけるブランド毀損リスク低減のためのサービス “Adveri.jp” を開発しています。また趣味として、自然言語処理エンジニア有志での論文読み会や雑談会もやっています。

本稿では、NLP若手の会 (YANS) 第14回シンポジウム (2019)の参加報告として、招待講演や個人的に注目した萌芽的研究の概観を中心に、自然言語処理の過去と現在、そしてこれからについての所感を書きます。また、企業に属する研究者・エンジニアとしてYANSを応援したい理由を、僭越ながら贈呈させていただいたスポンサー賞の詳細と併せてお伝えできればと思います。

内容は以下のような感じです:

- YANS2019の招待講演や発表内容からみる、自然言語処理のこれまでとこれから

- 個人的に興味を惹かれた萌芽的研究

- 企業のNLP研究者・エンジニアとして若手研究者コミュニティを応援する理由と、スポンサー賞

というわけで、本記事は多分にエモさが溢れています。あと、脚注がやたらと多いです。

なお、具体的な研究内容は過去の発表資料やこれからの対外活動をご参照ください。特に期間中の弊社の研究発表の様子は、個別記事①と個別記事② をお読みいただければと思います。

はじめに: NLPerといちばん深く話せる3日間

僕にとっては、合宿形式になって以来では、今回がはじめてのYANS参加となりました1。

実は僕自身は2013年に NAISTの自然言語処理学研究室 で修士課程を修了しているので、参加にあたって「若手とは……」という迷いも若干あったのですが、そんな迷いはすぐに払拭されるような、いつもどおりの暖かく議論が活発なNLPコミュニティを感じる2泊3日の集まりでした。

あと、僕は暑さに極端に弱いため、夏の終わりの札幌は涼しくて最高に過ごしやすかったです。おかげで(?)渋谷に帰ってからの出社が憂鬱で仕方ありません。ご飯も美味しかったし、また行きたいな……。

北の大地で「いまとこれからの言語処理」について考えてみる

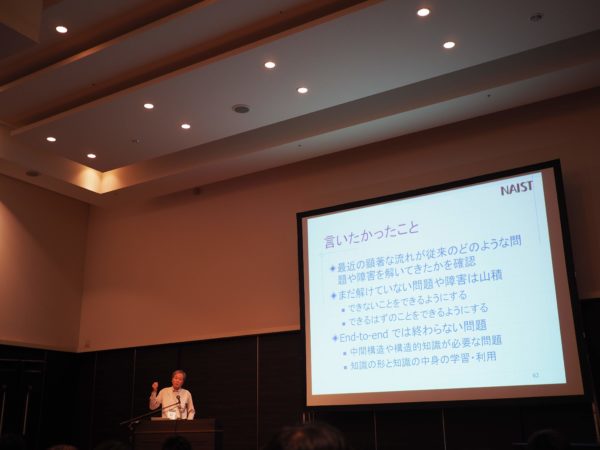

ここのタイトルは、NAIST時代の恩師である松本先生の招待講演『いまとこれからの言語処理を考える』をリスペクトしています。

松本先生の講演は、自然言語処理研究の黎明期から現在に至るまでをご自身の経歴とともに概観し、今後の自然言語処理分野に残された研究課題を論じるという内容です2。

なお、講演スライドは YANS2019公式サイト で公開が予定されていますので、正確な内容はそちらをご参照ください。

さて、自然言語処理は、計算機で人間のことば(自然言語)を扱い、なんらかの知的な作業を実現するということに重きを置いた分野だといえます3。

実際の言語現象を扱えるように、また、そのような基礎に乗っかって機械翻訳や対話生成のようなタスクを実現するために、文法規則やオントロジーの利用、統計的機械学習(最近では特に深層学習)による手法など、様々なパラダイムを経て研究が積み重ねられてきました。

昨今の何度目かの人工知能ブームの中でも、基盤技術のひとつとして捉えられることが多い自然言語処理ですが、こうした変遷を経て、何ができるようになって、一方で何がリサーチクエスチョンとして残っているのでしょうか。

まず、特に最近発展が目覚ましいトピックについて。

ひとつは単語単位の意味の取り扱いが進んだことです。Word2Vec4やGloVe5 をはじめとする手法により、大規模コーパスから分散表現 (Word Embedding) が得られるようになり、本来離散的な単語を連続的なベクトル空間で容易に扱えるようになりました6。膨大な語彙を数百次元のベクトルとして扱えるようになるという利便性や、意味的に近い単語の関係性の取得といった実タスクに役立つ性質だけでなく、そもそもなぜそのような類似性を扱えるのかの理由付け自体の研究も発展しています。

また、言語を系列としてうまく扱うという点では、RNN (Recurrent Neural Networks) の範疇にある各種のモデルや、長距離の関係を明示的に扱える注意機構 (Attention) の貢献が挙げられると思います。ELMo7 やBERT8 のように、こうしたメカニズムを発展させた手法は、先に挙げた単語単位の意味表現において文脈を考慮できるようにしただけでなく、文書分類や質問応答などの複数のタスクで利用できるモデルを獲得することができる点で、特筆すべきものだといえそうです。

このような進歩によって、これまでのようなパイプライン(=形態素解析・構文解析・応用解析など)を必要としないEnd-to-Endな手法が提案され、機械翻訳や質問応答など、高度なタスクの現実性はかなり高いところまで到達しました。

実用が見えてきたタスクが数多くある一方、残された課題もあります。

たとえば、End-to-Endな手法では難しい、中間的な構造や知識(形態論的なものや句構造など)が必要な場合です:

- 出力結果の理由や根拠の説明、解釈の支援が必要なタスク

- たとえば言語学習者への教育支援。文法や表現の誤りを訂正するときに、「なぜここが誤りか」、「こう直すとなぜ良いのか」という出力がある方が良い。

- よくある言語現象の取り扱いには、言語の構造に対する知識が必要?

- 単語により構文が影響されるケース

- 並列構造や複文、埋め込み文などの統語的な複雑性が高いケース9

このように、まだ綺麗に解けていない問題に取り組むには、様々なレベルの構造を知識としてモデルに組み込むことが必要となりそうです。

僕の場合は、自然言語処理の応用面に関わっているという立場上、ドメイン知識や言語学的な知識を使って済む場合はそうしたいと思っています。それでも、BERTのようなEnd-to-Endなモデルを使う際には、「いやぁ便利になったなぁ……」という心の声が出てしまいます。この講演後、必要な場合には言語自体への知見に基づいて、「割に合う」手法を考案できるようにしたいという初心を思い出しました。

YANSだからこそわかる、これからのNLP

YANSは発足当初から、萌芽的な研究やアイデアレベルの内容について、その場で議論し合える場を重視しているイベントです。

これから始まる,または始まったばかりの研究の発表を歓迎します.本シンポジウムでの活発な議論を通じて,研究の進展を促進することを目指します. — YANSの発表募集要項

今回僕は特に萌芽的な研究を聴きたいと思い、以下のような発表を中心に回っていました。

- タスクとして新しいもの

- 以前からある言語現象をモダンな手法で扱えるように工夫したもの

- 自分が以前テーマとしていた言語学習者支援の研究

以下ではそれらのうち一部を紹介します。ただしYANSの意義はライブ感のある議論だと思うので、ここではごく簡単なコメントをするだけにとどめておきます。

- 文脈を考慮した単語分散表現や意味ベクトルの埋め込みは色々あるが、語構造・句構造を扱えるような工夫があった。

- 言語学習者支援: より広範な言語へ、より深い支援へ。

- メジャーなタスクに対して、有効な飛び道具的なマルチモーダル手法が面白かった。

なお、ポスターは YANS2019プログラム で一般公開が始まっています。

YANS2019スポンサー賞(あるいはスポンサーとなる意義)

今回、弊社はプラチナスポンサーとしてYANS2019を微力ながら支援させていただきました。

企業としての意義は色々あるらしいのですが、いちNLPエンジニアの気持ちとしては、研究コミュニティに少しでも恩返しがしたいというのが一番の理由です。

もう少し詳しくいえば、2つの観点があります。

まず一つ目は、直接得ている便益に対する感謝です。こちらは自然言語処理を実用して利益を得ている立場にいます。OSSの開発やそれを利用するという文脈とほぼ同じです。

特にYANSは、新しいアイデアの議論が中心となっているため、NLPの実用面での課題を研究コミュニティに意思表示できる場であり、同時に、貴重なフィードバックをいただくことにもなります。また、個人としても研究コミュニティに助けられた経験もあります10。たとえば、実際にプロダクトに利用している手法も、YANS2018における国際会議参加報告で知ることができたという、コミュニティに大きく助けられた例もあります11。

もう一方の意義としては、自身が育てられた自然言語処理研究コミュニティとその自由闊達な環境を繋いでいきたいというものです。YANSポスター発表が中心なので議論がしやすいですし、合宿形式なので、「言語処理界のあの人!」みたいな人とも急に雑談が始まったりします。進路についての悩みも、ここなら相談しやすいですし。

深い議論を気軽にできる研究コミュニティが維持できるように、また、自分が属するところにも作りたい。社内外関わらず、僕の周りの企業NLP研究者・エンジニアもこうした動機でやっているような気がします。

サイバー賞

こうした観点も踏まえて、今回は「サイバー賞」を、阪大の芦原さんの研究に差し上げることになりました🎉

シンプルなモデルで修飾関係を含められる分散表現という実用上の興味や、より広範囲の構文構造を扱えるという発展性から、選定させていただきました!

おわりに

長々とエモい話を書かせてもらいましたが、一言で言えば「みんなYANSに行ってみよう」ということです!

最後になってしまいましたが、参加者のみなさま、YANS運営のみなさまには深くお礼申し上げます。

- 正確には、以前NAISTで行われたYANSシンポジウム以来ですね、というと、時の流れをひしひしと感じてしまいます。 ↩

- 僕自身は、すでに大規模コーパスが揃いはじめ、各種の機械学習手法が主流になって以降の自然言語処理しか経験していません。ですが、NAIST時代に雑談で先生が話していたような、論理ベース、知識・オントロジーベースの手法が活発だった時代の話、そして(これはやけに記憶に残っていますが)国プロからNAISTに移るまでの話と当時の研究環境など、少し懐かしい気持ちになる講演でした。 ↩

- 隣接、あるいは重複する研究領域として計算言語学 (Computational Linguistics) がありますが、自然言語処理の方はそれと比べると実応用やエンジニアリング的側面にも興味を持っているコミュニティである気がします。 ↩

- Mikolov, Tomas, Kai Chen, Greg Corrado, and Jeffrey Dean. “Efficient Estimation of Word Representations in Vector Space.” ArXiv:1301.3781 [Cs], January 16, 2013. http://arxiv.org/abs/1301.3781. ほか。 ↩

- Pennington, Jeffrey, Richard Socher, and Christopher D Manning. “GloVe: Global Vectors for Word Representation.” Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing, 2014, 1532–43. https://doi.org/10.3115/v1/D14-1162. ↩

- ただし、単語や依存構造などを連続的なベクトル空間で表すこと自体は、古くからあるものです。 ↩

- Peters, Matthew, Mark Neumann, Mohit Iyyer, Matt Gardner, Christopher Clark, Kenton Lee, and Luke Zettlemoyer. “Deep Contextualized Word Representations.” In Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long Papers), 2227–2237. New Orleans, Louisiana: Association for Computational Linguistics, 2018. https://doi.org/10.18653/v1/N18-1202. ↩

- Devlin, Jacob, Ming-Wei Chang, Kenton Lee, and Kristina Toutanova. “BERT: Pre-Training of Deep Bidirectional Transformers for Language Understanding.” ArXiv Preprint, October 11, 2018. https://doi.org/arXiv:1811.03600v2. ↩

- 例えば、並列構造(並列句)の場合は、並列句それ自体が文中に複数存在したり入れ子の構造になることもあり、難しい問題の一つです。最近の研究としては、寺西裕紀, 進藤裕之, 松本裕治. “ニューラルネットワークに基づく並列句表現の学習と構造解析.” 研究報告自然言語処理(NL)2017-NL-232, no. 5 (July 12, 2017): 1–7. など。 ↩

- たとえば、国内学会・研究会で受けたコメントや議論からアイデアが深化して、トップカンファレンス論文までうまく持っていけた、というようなこと。このあたりのメリットは鈴木先生の招待講演が面白かったです。僕も今のジョブを得たのは、ACLに一本通していたというのをLinkedInに書いておいたら、弊社の人事がそれを見てコンタクトを取ってくれたということがあったからです。 ↩

- 学習済みの分散表現を基底ベクトルの組み合わせで表現することで、大幅にサイズを削減する手法。言語モデルの再学習が必要ない点や、NLPコンテナの起動時間やリクエストのペイロードサイズの削減ができた。 Shu, Raphael, and Hideki Nakayama. “Compressing Word Embeddings via Deep Compositional Code Learning.” In Proceedings of the International Conference on Learning Representations (ICLR), 1–13, 2018. http://arxiv.org/abs/1711.01068. ↩

Author