Blog

多言語モデルXGLMによる日本語テキストの自動生成

AI Lab NLPチームの星野 (@shhshn) です。この記事ではMeta(旧称Facebook)社が2021年末に発表した多言語モデルXGLM [1] を日本語テキストの自動生成タスクで試した結果について紹介します。

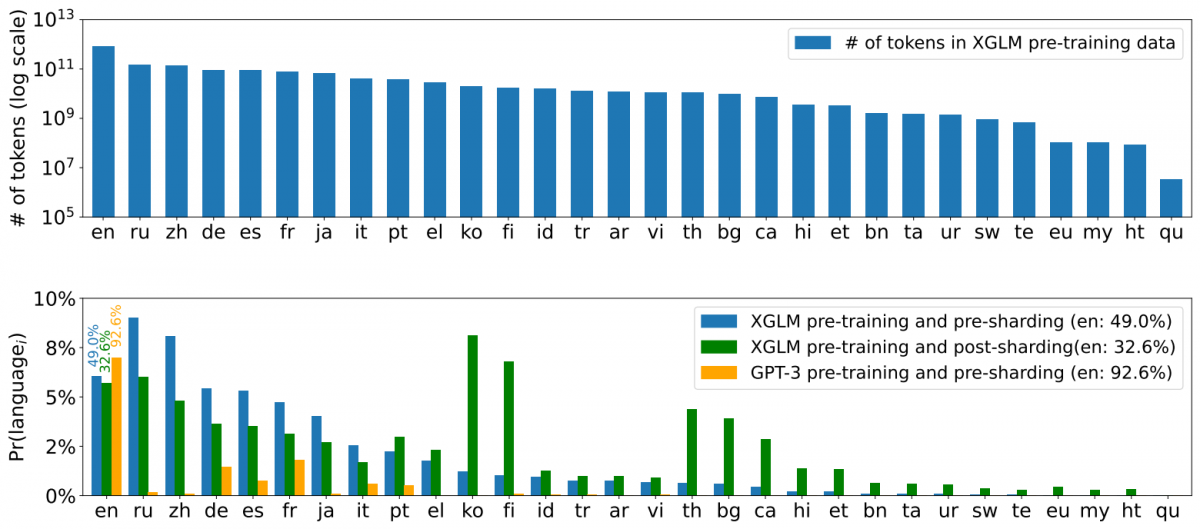

論文 [1] より引用

はじめに

XGLMは、GPT-3 [2] に代表されるテキスト生成のための事前学習済み言語モデルで、テキストの断片 (prompt) を入力するとその続きを出力します。例えば「昔々」と入力すると「あるところに」と尤もらしい続きを出力することが期待されます。特にGPT-3では少量の訓練事例をpromptとして与えるfew-shot learningによって出力を制御でき、手間のかかるfine-tuningによる追加学習を実施せずとも様々なタスクで性能を発揮することが示されています。事前学習済みモデルのスケール性について論じたscaling laws [3] や、転移学習の文脈でのfoundation modelの議論 [4] も有名です。

このように便利な事前学習済みモデルですが、学習に大規模データを必要とするため、公開されるモデルはどうしても英語が中心になりがちです。例えば日本語のモデルにはrinna社のGPT-2 [5] がありますが、より大規模なGPT-3相当のモデルは現時点で公開されていません。単言語のモデルとは別の方向性として多言語モデルも数多く提案されており、例えばmBART [6] やXLM-R [7] がありますが、テキスト生成に特化したモデルではなくfew-shot learningでGPT-3ほどの実力があるか不明でした。そこでGPT-3と同等の性質・性能を兼ね備えた多言語モデルとして提案されたのが今回のXGLMです。

XGLMの使い方

それでは実際にXGLMを動かして日本語テキストを生成できるか確かめます。

インストール

論文著者らによる公式実装とモデルが公開されていますが、簡単化のためにHugging Face社による再実装 [8] で代用します。サブワード化のためにSentencePiece [9] もインストールします。実行環境にはGoogle Colaboratoryの無料GPUランタイムを使用します。

|

1 2 |

!pip install -q git+https://github.com/huggingface/transformers.git !pip install -q sentencepiece |

次にXGLMをダウンロードします。パラメタ数 564M〜7.5B の様々なサイズのモデルが用意されていますが、今回は実行環境の都合により最小の564Mモデルを使用します。

|

1 2 3 |

from transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("facebook/xglm-564M") model = AutoModelForCausalLM.from_pretrained("facebook/xglm-564M") |

モデルを読み込み終わったらGPU上に移動しておきます。

|

1 2 3 4 5 6 |

import torch torch.manual_seed(0) device = "cuda:0" if torch.cuda.is_available() else "cpu" model = model.eval() model = model.half() model = model.to(device) |

Zero-shot Learning

まずはXGLMが最も得意とする英語のテキスト生成から試します。英語のprompt「Once upon a time」を入力すると、「there was a man named John …」といかにも小説の冒頭にありそうなテキストが出力されました。

|

1 2 3 4 5 |

prompt = """Once upon a time""" input = tokenizer.encode(prompt, return_tensors="pt").to(device) output = model.generate(input) tokenizer.batch_decode(output, skip_special_tokens=True)[0] # Once upon a time, there was a man named John, who was a man of great wealth |

同様に日本語のテキスト生成を試します。日本語のprompt「昔々あるところに」を入力しすると、「のが置いてあった。」と残念ながら流暢ではないテキストが出力されました。

|

1 2 3 4 5 |

prompt = """昔々あるところに""" input = tokenizer.encode(prompt, return_tensors="pt").to(device) output = model.generate(input) tokenizer.batch_decode(output, skip_special_tokens=True)[0] # 昔々あるところに、のが置いてあった。 |

英語と比べて日本語は不得手なようで、生成手法をnucleus sampling [10] に変更すると「ドリームポイントやメインダイナミックポイントがあった」とより流暢なテキストが出力されます。

|

1 2 3 |

output = model.generate(input, do_sample=True, top_k=0, top_p=0.95) tokenizer.batch_decode(output, skip_special_tokens=True)[0] # 昔々あるところにドリームポイントやメインダイナミックポイントがあった |

このように単一のモデルでありながら入力言語に応じた出力が得られ、まぎれもなく多言語モデルになっていると分かります。一方で、言語の違いがテキスト出力の質にも影響します。

Few-shot Learning

次に少量の訓練事例をpromptとして与えるfew-shot learningを試します。簡単な例として、算数を解くタスクの正解として「1 + 1 = 2」と「2 + 3 = 5」の2つを与えて「3 + 5」の結果を予測させます。すると不正解の「6」が出力されました。この結果から、シンボリックな演算は行っていませんが、promptの文脈に対応して数字だけでも出力しようとしていることが分かります。

|

1 2 3 4 5 6 7 8 |

prompt = """足し算: 1 + 1 = 2 2 + 3 = 5 3 + 5 = """ input = tokenizer.encode(prompt, return_tensors="pt").to(device) output = model.generate(input) tokenizer.batch_decode(output, skip_special_tokens=True)[0] # 足し算: 1 + 1 = 2 2 + 3 = 5 3 + 5 = 6 |

より複雑な例として、自然言語処理でよくある固有名詞の抽出タスクを試します。正解として「東京スカイツリー」と「富士山」の2つを与えて「サイバーエージェント」について予測させると、想定通りに固有名詞として出力されました。

|

1 2 3 4 5 6 7 8 |

prompt = """固有名詞: 一番高い建物は東京スカイツリーです = 東京スカイツリー 一番高い山は富士山です = 富士山 サイバーエージェントでは広告を研究しています = """ input = tokenizer.encode(prompt, return_tensors="pt").to(device) output = model.generate(input, max_length=100, truncation=True, padding="max_length") tokenizer.batch_decode(output, skip_special_tokens=True)[0] # 固有名詞: 一番高い建物は東京スカイツリーです = 東京スカイツリー 一番高い山は富士山です = 富士山 サイバーエージェントでは広告を研究しています = サイバーエージェント 広告研究室 |

単言語モデルとの比較

参考までに、XGLM 564Mモデルとほぼ同サイズのrinna社GPT-2 mediumモデルでの出力を掲載します。なおrinna社からは先日、より大規模なGPTモデルが公開されました。

|

1 2 3 4 5 6 7 8 9 |

from transformers import T5Tokenizer, AutoModelForCausalLM tokenizer = T5Tokenizer.from_pretrained("rinna/japanese-gpt2-medium") tokenizer.do_lower_case = True model = AutoModelForCausalLM.from_pretrained("rinna/japanese-gpt2-medium") prompt = """昔々あるところに""" input = tokenizer.encode(prompt, return_tensors="pt").to(device) output = model.generate(input, do_sample=True, top_k=0, top_p=0.95) tokenizer.batch_decode(output, skip_special_tokens=True)[0] # 昔々あるところに香川照之様がありました。 |

おわりに

多言語モデルXGLMを使用することで、英語の言語モデルと同様の感覚で日本語のテキストを自動的に生成できました。実用上は多言語モデルゆえのサイズ感など従来の単言語モデルと一長一短ありますが、応用先として複数言語を単一モデルで処理する言語横断的な使い方などが考えられます。

参考文献

- [1] Xi Victoria Lin, Todor Mihaylov, Mikel Artetxe, Tianlu Wang, Shuohui Chen, Daniel Simig, Myle Ott, Naman Goyal, Shruti Bhosale, Jingfei Du, Ramakanth Pasunuru, Sam Shleifer, Punit Singh Koura, Vishrav Chaudhary, Brian O’Horo, Jeff Wang, Luke Zettlemoyer, Zornitsa Kozareva, Mona Diab, Veselin Stoyanov, and Xian Li. Few-shot Learning with Multilingual Language Models. arXiv:2112.10668

- [2] Tom Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared D Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Tom Henighan, Rewon Child, Aditya Ramesh, Daniel Ziegler, Jeffrey Wu, Clemens Winter, Chris Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, and Dario Amodei. Language Models are Few-Shot Learners. NeurIPS 2020

- [3] Jared Kaplan, Sam McCandlish, Tom Henighan, Tom B. Brown, Benjamin Chess, Rewon Child, Scott Gray, Alec Radford, Jeffrey Wu, and Dario Amodei. Scaling Laws for Neural Language Models. arXiv:2001.08361

- [4] Rishi Bommasani, Drew A. Hudson, Ehsan Adeli, Russ Altman, Simran Arora, Sydney von Arx, Michael S. Bernstein, Jeannette Bohg, Antoine Bosselut, Emma Brunskill, Erik Brynjolfsson, Shyamal Buch, Dallas Card, Rodrigo Castellon, Niladri Chatterji, Annie Chen, Kathleen Creel, Jared Quincy Davis, Dora Demszky, Chris Donahue, Moussa Doumbouya, Esin Durmus, Stefano Ermon, John Etchemendy, Kawin Ethayarajh, Li Fei-Fei, Chelsea Finn, Trevor Gale, Lauren Gillespie, Karan Goel, Noah Goodman, Shelby Grossman, Neel Guha, Tatsunori Hashimoto, Peter Henderson, John Hewitt, Daniel E. Ho, Jenny Hong, Kyle Hsu, Jing Huang, Thomas Icard, Saahil Jain, Dan Jurafsky, Pratyusha Kalluri, Siddharth Karamcheti, Geoff Keeling, Fereshte Khani, Omar Khattab, Pang Wei Koh, Mark Krass, Ranjay Krishna, Rohith Kuditipudi, Ananya Kumar, Faisal Ladhak, Mina Lee, Tony Lee, Jure Leskovec, Isabelle Levent, Xiang Lisa Li, Xuechen Li, Tengyu Ma, Ali Malik, Christopher D. Manning, Suvir Mirchandani, Eric Mitchell, Zanele Munyikwa, Suraj Nair, Avanika Narayan, Deepak Narayanan, Ben Newman, Allen Nie, Juan Carlos Niebles, Hamed Nilforoshan, Julian Nyarko, Giray Ogut, Laurel Orr, Isabel Papadimitriou, Joon Sung Park, Chris Piech, Eva Portelance, Christopher Potts, Aditi Raghunathan, Rob Reich, Hongyu Ren, Frieda Rong, Yusuf Roohani, Camilo Ruiz, Jack Ryan, Christopher Ré, Dorsa Sadigh, Shiori Sagawa, Keshav Santhanam, Andy Shih, Krishnan Srinivasan, Alex Tamkin, Rohan Taori, Armin W. Thomas, Florian Tramèr, Rose E. Wang, William Wang , Bohan Wu, Jiajun Wu, Yuhuai Wu, Sang Michael Xie, Michihiro Yasunaga, Jiaxuan You, Matei Zaharia, Michael Zhang, Tianyi Zhang, Xikun Zhang, Yuhui Zhang, Lucia Zheng, Kaitlyn Zhou, and Percy Liang. On the Opportunities and Risks of Foundation Models. arXiv:2108.07258

- [5] 趙 天雨 and 沢田 慶. 日本語自然言語処理における事前学習モデルの公開. 人工知能学会 言語・音声理解と対話処理研究会 第93回研究会

- [6] Yinhan Liu, Jiatao Gu, Naman Goyal, Xian Li, Sergey Edunov, Marjan Ghazvininejad, Mike Lewis, and Luke Zettlemoyer. Multilingual Denoising Pre-training for Neural Machine Translation. TACL 2020

- [7] Alexis Conneau, Kartikay Khandelwal, Naman Goyal, Vishrav Chaudhary, Guillaume Wenzek, Francisco Guzmán, Edouard Grave, Myle Ott, Luke Zettlemoyer, and Veselin Stoyanov. Unsupervised Cross-lingual Representation Learning at Scale. ACL 2020

- [8] Thomas Wolf, Lysandre Debut, Victor Sanh, Julien Chaumond, Clement Delangue, Anthony Moi, Pierric Cistac, Tim Rault, Remi Louf, Morgan Funtowicz, Joe Davison, Sam Shleifer, Patrick von Platen, Clara Ma, Yacine Jernite, Julien Plu, Canwen Xu, Teven Le Scao, Sylvain Gugger, Mariama Drame, Quentin Lhoest, and Alexander Rush. Transformers: State-of-the-Art Natural Language Processing. ACL 2020

- [9] Taku Kudo and John Richardson. SentencePiece: A simple and language independent subword tokenizer and detokenizer for Neural Text Processing. EMNLP 2018

- [10] Ari Holtzman, Jan Buys, Li Du, Maxwell Forbes, and Yejin Choi. The Curious Case of Neural Text Degeneration. ICLR 2020

Author