Blog

【採択論文紹介】BareSkinNet: De-makeup and De-lighting via 3D Face Reconstruction

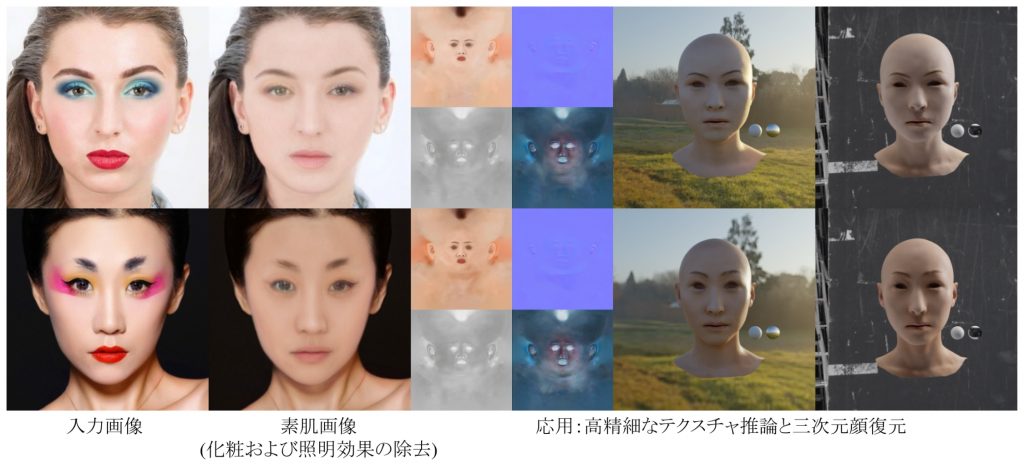

AI Lab Graphicsチームの武富です.この記事では,コンピュータグラフィックス分野において,著名な国際会議であるPacific Graphics 2022に採択された以下の論文について紹介します.紹介する論文では,入力された1枚の顔画像から化粧と照明の影響を除去した画像を出力する手法の提案を行っています(図1).このような処理は,素肌の状態の3次元顔モデルを作成するための前処理として利用でき,化粧や照明の影響を排除しておくことで後から3DCGアーティストの手によって様々な化粧を付加しやすくなるという利点があります.

BareSkinNet: De-makeup and De-lighting via 3D Face Reconstruction

Xingchao Yang, Takafumi Taketomi

図1 左から入力画像,化粧および照明効果を除去した画像,3D顔モデルの復元とレンダリング結果.

研究のアイデア

顔画像中の化粧を除去するための一つの方法として,化粧転写技術を用いることができます.一般に,化粧転写技術では,参照用の顔画像を用意し対象となる顔画像に参照用顔画像の化粧を転写します.このとき,化粧を施していない顔画像を参照用画像として指定することで,顔画像中の化粧を取り除くことが可能です.しかしながら,既存の手法では,照明の効果が考慮されていないため,化粧除去後の画像にハイライトなどの情報が残ってしまいます.このような照明情報は,正規化されたテクスチャマップの生成の際に問題となります.そこで,本研究では,顔のパラメトリックモデルである3D Morphable Model (3DMM)を活用することで,化粧の除去と照明効果の除去を同時に実現することを可能としました.また,3DMMを活用することによって,提案手法では参照用の顔画像を推論時に用いることなく,化粧の除去が可能となっています.

BareSkinNet: 3DMMを活用した化粧と照明の除去ネットワーク

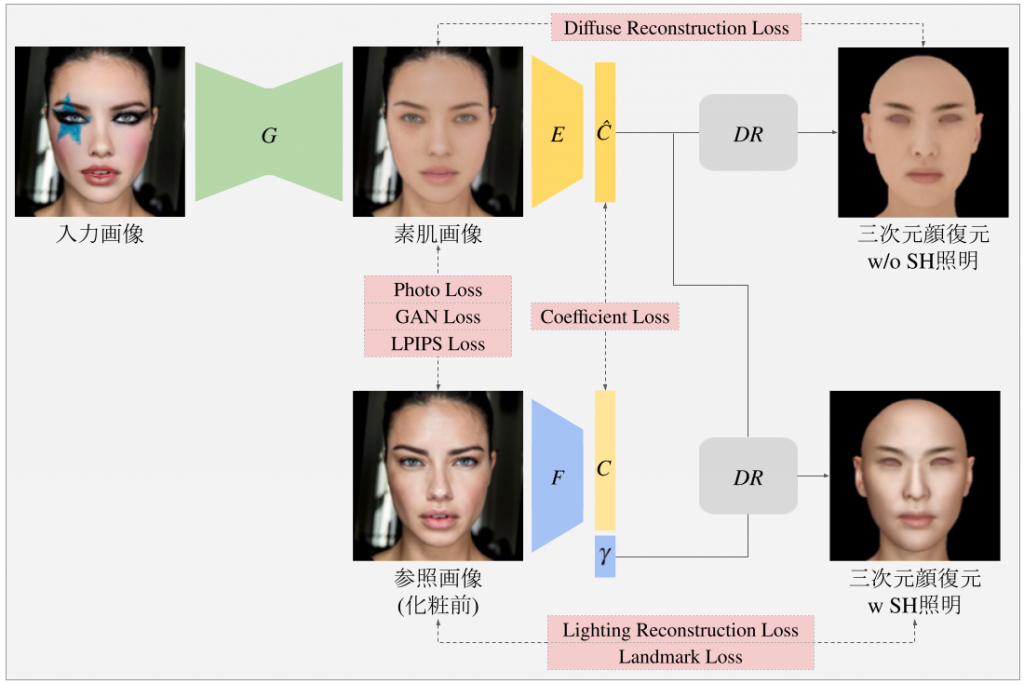

図2にBareSkinNetの概要を示しています.BareSkinNetは化粧と照明の除去を行うネットワークGと3DMMを当てはめることによって顔画像から3Dの顔を復元するネットワークE, Fから構成されています.学習には,化粧を施す前後のペア画像が含まれているLADN Dataset [1]を用います.ポイントは,化粧と照明を除去した画像(bare skin image)に対しては,Spherical Harmonics (SH)による照明を利用せずに3DMMをレンダリングした画像との損失を計算し,化粧前のreference imageに対してはSHによる照明を施したレンダリング画像との損失を計算しているところです.これにより,照明効果の除去と化粧の除去を同時に実現しています.また,工夫として,LADN Datasetに含まれる顔画像は少数であるため,大規模な顔画像データセットで学習済みの3D顔復元ネットワークFをガイドとして用いることで安定した学習を実現しています.

図2 BareSkinNetの概要.BareSkinNetは化粧と照明効果を除去するネットワークGと顔の3D復元を行うネットワークE, Fで構成される.ネットワークFには事前学習済みのネットワークを用いることで,学習の安定化を図っている.

既存手法との比較

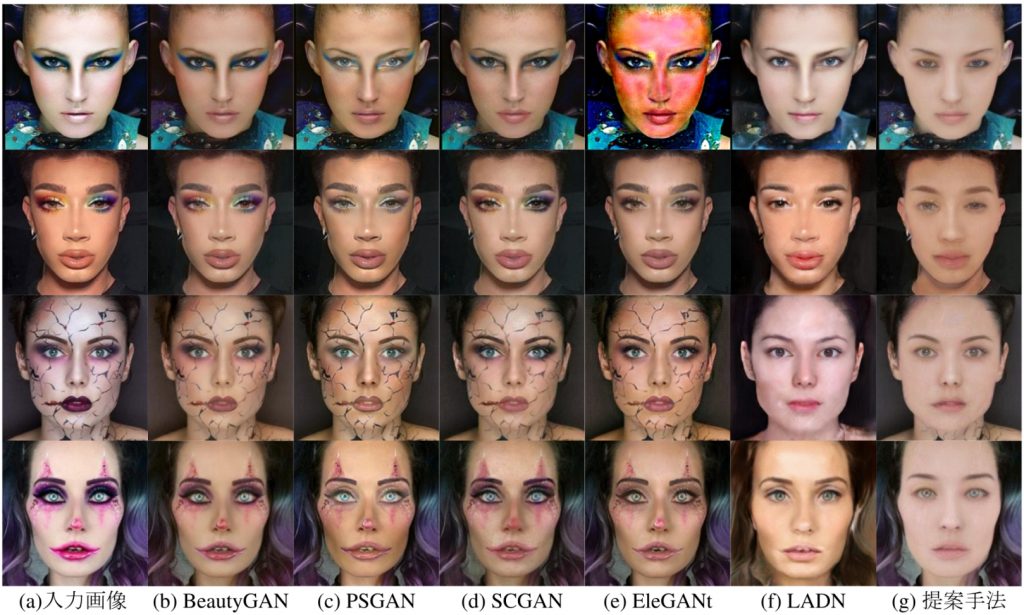

代表的な化粧転写手法との比較結果を図3に示します.ここでは,特に濃い化粧が施されている顔画像に対する結果を示しています.ほとんどの手法では,処理結果の画像に化粧の影響が残っていることが確認できます.また,LADN [1]では,一見化粧の影響を取り除くことができていますが,参照している画像の影響を受けて新たな照明効果やハイライトが生じていることが確認できます.一方で,提案手法では,化粧および照明効果の両方が除去できていることが確認できます.

図3 化粧および照明効果の除去結果の比較.

3次元顔モデルのためのテクスチャマップ生成への応用

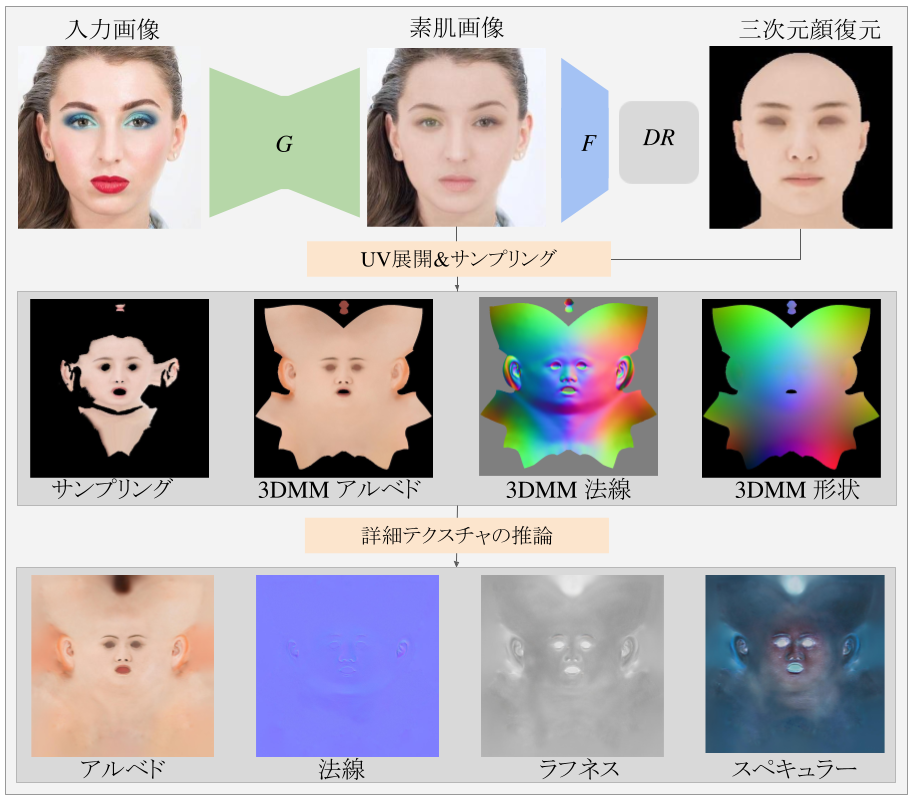

応用として,BareSkinNetによって出力されたbare skin imageと顔の3次元復元結果を用いて,高精細なテクスチャマップの生成を行いました.ここでは,図4に示すように,画像変換の技術を用いて,入力画像からサンプルされたテクスチャと3DMMから取得されるマップを入力とし,4K解像度のdiffuse, normal, roughness, specularのテクスチャマップの生成を実現しています.テクスチャ生成のネットワークの学習には,独自に取得した日本人女性200名のスキャンデータを利用しています.このネットワークで生成されるテクスチャマップを用いることで,図1の右に示すようなフォトリアルなモデルのレンダリングが可能となります.

図4 BareSkinNetから出力された化粧と照明効果が除去された画像と3D顔復元結果の情報から,物理ベースレンダリングで用いられるdiffuse, normal, roughness, specularの4Kテクスチャマップを生成する.

まとめ

この研究では,3DMMを活用することによって顔画像中の化粧と照明効果を同時に除去する手法の提案を行いました.実験を通して,我々が提案する手法は,既存の手法よりも安定して化粧および照明の影響を除去することができることを確認しました.本ブログでは,論文の概要についての紹介となっているため,ご興味のある方はぜひ論文を読んでいただきたいと思います.

[1] Qiao Gu, Guanzhi Wang, Mang Tik Chiu, Yu-Wing Tai, Chi-Keung Tang, “LADN: Local Adversarial Disentangling Network for Facial Makeup and De-Makeup”, Proceedings of the IEEE International Conference on Computer Vision, pp. 10481-10490, 2019.

[2] Tingting Li , Ruihe Qian , Chao Dong , Si Liu , Qiong Yan , Wenwu Zhu , Liang Lin, “BeautyGAN: Instance-level Facial Makeup Transfer with Deep Generative Adversarial Network”, Proceedings of the ACM international conference on Multimedia, pp. 645-653, 2018.

[3] Wentao Jiang, Si Liu, Chen Gao, Jie Cao, Ran He, Jiashi Feng, Shuicheng Yan, “PSGAN: Pose and Expression Robust Spatial-Aware GAN for Customizable Makeup Transfer”, Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 5194-5202, 2020.

[4] Han Deng, Chu Han, Hongmin Cai, Guoqiang Han, Shengfeng He, “Spatially-invariant Style-codes Controlled Makeup Transfer”, Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 6549-6557, 2021.

[5] Chenyu Yang, Wanrong He, Yingqing Xu, Yang Gao, “EleGANt: Exquisite and Locally Editable GAN for Makeup Transfer”, Proceedings of European Conference on Computer Vision, 2022.

Author