Blog

【採択論文紹介】Garment Model Extraction from Clothed Mannequin Scan

AI Lab Graphicsチームの高です。この記事では、コンピュータグラフィックス分野における論文誌「Computer Graphics Forum」に採択されたスキャンデータから衣服を自動抽出する論文の内容について紹介します。

Garment Model Extraction from Clothed Mannequin Scan

はじめに

高品質なデジタルヒューマンを作成するうえで、衣服はコンテンツの写実性を向上させる重要な要素の1つです。しかしながら、高精細な衣服のモデリングにはCGアーティストの多大な労力や経験が必要とされるため、衣服のモデリングの自動化が重要な課題となっています。そこで本研究では、マネキンにモデリング対象の衣服を着衣させた状態でフォトグラメトリー技術等を用いて復元した3Dモデルから高精細なテクスチャ(模様)付き衣服モデルを自動抽出することを実現しました。

着衣した人物のスキャンデータから衣服を抽出する研究[1][2][3]はありますが、既存研究では基本的に着衣していない状態の人体の3Dモデル(SMPL Model[4]等)を利用しているため、体系に沿ったタイトな衣服については頑健に抽出することが可能ですが、スカートやワンピースなどの人体表面から大きく離れるような構造を有する衣服への対応が難しいという問題点があります。このような問題に対して、本研究では、衣服のタイトさを自動判別することで、タイトな衣服もスカートやワンピースなどの衣服も頑健に抽出できる手法を提案しています。

図1 提案手法の概要。まず、色情報に基づいた境界線の抽出によって衣服領域を抽出する。その後、衣服のタイトさについて自動判別しスカートなどのルースな衣服については形状情報に基づく追加処理を行う。

提案手法

本研究では、実世界の衣服を体にぴったりとフィットするような衣服(タイトな衣服)と、体から大きく離れた部分が存在する衣服(ルースな衣服)の2種類に分類し取り扱います。図1に示すように、提案手法では、2段階の処理でタイトな衣服とルースな衣服の両方の自動抽出を実現しています。第1段階では、マネキンの色情報やマネキンの四肢の方向などの事前情報を用いた抽出を行います。タイトな衣服については、事前情報を用いた処理により抽出することが可能です。より詳細な処理の内容については、論文を参照して頂ければと思います。第1段階の処理が終了した後、抽出された衣服の袖や裾付近における着衣したマネキンの断面と裸マネキンの断面との推定面積の比率によりルースな衣服を自動判別します。ルースな衣服として判定されたものについては、追加の処理として形状情報に基づく衣服境界の抽出を行います。

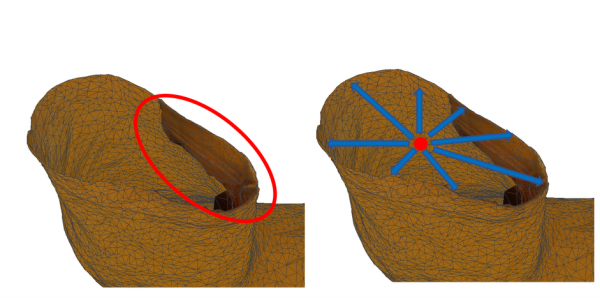

図2 衣服と体との間の「隙間」の例

ルースな衣服では、図2に示すように、衣服と体との間に大きな隙間が存在する場合があります。このような領域はスキャンの際に遮蔽領域となっていることが多く観測値が無い場合があります。RealityCapture [5]などの多くの3次元復元ソフトウェアでは、このような観測値が無い領域に対して自動的に穴埋め処理が施され3次元のメッシュが生成されます。このような領域に対応するテクスチャは周囲の観測されている色情報から補間されることになります。

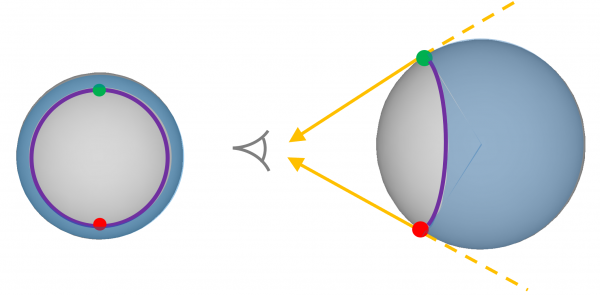

そのため、単純に色情報のみを利用して衣服を抽出した場合、図3(左)に示すように、抽出された衣服の開口部周辺に不要なメッシュが残ってしまいます。本研究では、衣服の開口部をトレースする曲線を衣服の本来の境界と考え、輪郭線という概念に着目しました。図4に示すように、輪郭線はある視点から物体を観測する際に、視線と物体の輪郭が接する点の集合になります。物体上の可視部分と不可視部分との境界線とみなすこともできます。図3(右)に示すように、色情報を用いて抽出された衣服の開口部中心付近に一つのアンカーポイント(赤い点)を設置した場合、そこから観測される輪郭線を衣服の境界とみなすことができます。

本研究ではメッシュ上のエッジの列で境界線を近似しているため、輪郭線が通過するエッジ上からメッシュの頂点をサンプリングし制御点とした上で、「曲率」を考慮した重みを設計して、制御点間の重み付き最短経路からなるループを衣服とマネキンとの最終的な境界線としています。

図3 左)色情報のみを利用した抽出結果に余分なメッシュが残る場合がある。 右)赤いアンカーポイントから観測される「輪郭線」を衣服の「境界」とみなすことができます。

図4 ある視点から観測できる物体上の輪郭線(紫の曲線)。左)正面からのビュー。右)側面からのビュー。

実験結果

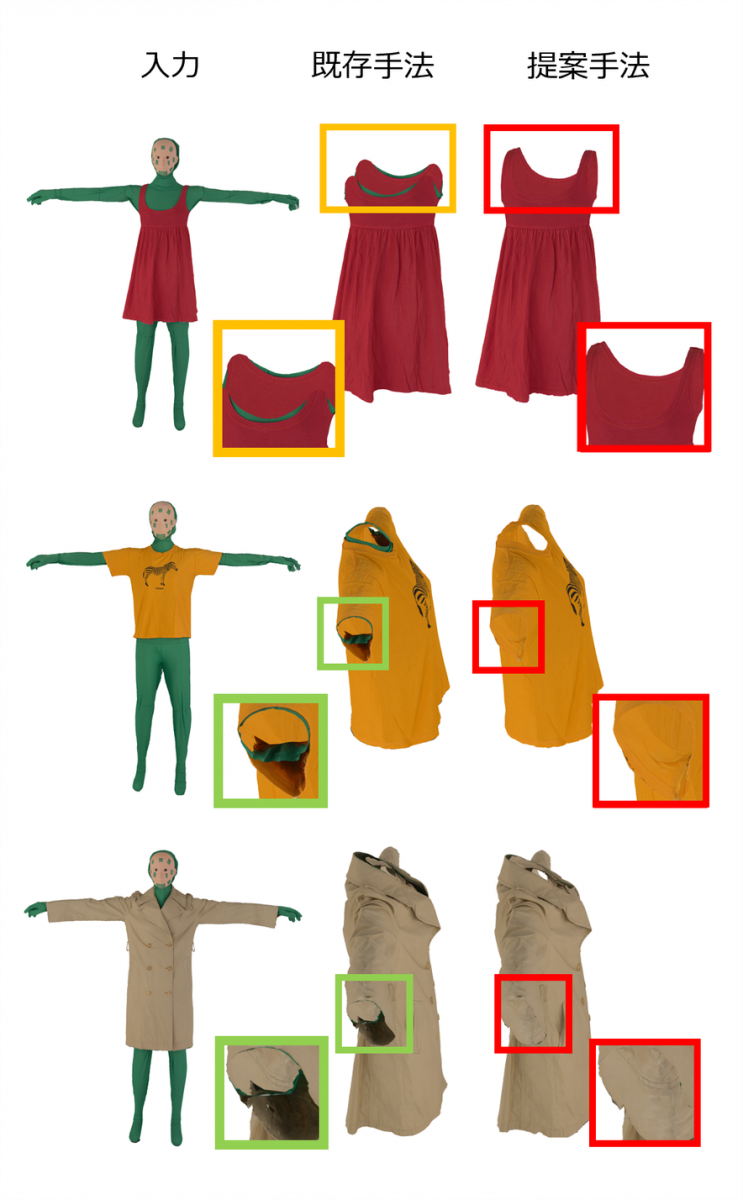

図5に、既存手法[3]と提案手法による衣服の抽出結果例を示しています。既存手法では、衣服の特徴的な構造(ワンピースのストラップ)が失われる場合や、衣服と体との隙間部分に不必要なメッシュが残る場合が確認できます。一方で、提案手法では、全ての衣服で高精度な抽出を実現できています。

図5 既存手法と提案手法による抽出結果の比較例

まとめ

既存手法ではルースな衣服の抽出が困難であるという問題がありました。これに対して、単一の処理パイプラインでタイト・ルース双方の衣服を高精度で抽出できるようになった点が本研究のポイントとなっています。また、抽出した衣服は図6に示すように、既存のシミュレーションソフトウェアで利用可能です。

図6 Marvelous Designer[6]を用いたシミュレーションの結果例

[1] Pons-Moll G., Pujades S., Hu S., Black M. J.: ClothCap: seamless 4D clothing capture and retargeting. ACM Transactions on Graphics 36, 2017, 73:1– 73:15.

[2] Bhatnagar B. L., Tiwari G., Theobalt C., Pons-Moll G.: Multi-garment net: Learning to dress 3D people from images. In Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision (ICCV), 2019, pp. 5419– 5429.

[3] Bang S., Korosteleva M., Lee S.-H.: Estimating garment patterns from static scan data. Computer Graphics Forum 40, 2021, DOI:10.1111/cgf.14272.

[4] Loper M., Mahmood N., Romero J., Pons-Moll G., Black M. J.: SMPL: A skinned multi-person linear model. ACM Transactions on Graphics (Proc. SIGGRAPH Asia) 34, 6 (Oct. 2015), 248:1– 248:16.

[5] Capture Reality Community: RealityCapture. https://www.capturingreality.com/realitycapture (2023).

[6] CLO Virtual Fashion, Inc.: MarvelousDesigner. https://www.marvelousdesigner.com/ (2023).

Author